Trouver une connexion Internet adaptée à une PME c’est vite le parcours du combattant.

Notre besoin initial c’est le surf web de tous les jours pour une petite dizaine de personnes, les petits téléchargements, les mails, les pièces jointes parfois un peu volumineuse, la téléphonie voip, et exceptionnellement des téléchargements de backups ou des envois de données sur les serveurs de production.

Pour traduire ça en caractéristiques techniques, les coupures sont critiques comme pour tout le monde, mais nous ne mourrons pas si nous avons quelques heures d’indisponibilités une ou deux fois dans l’année. Nous n’utiliserons pas forcément une bande passante moyenne énorme, mais quand il faut envoyer un fichier de 20 Mo, descendre une sauvegarde de la base de données ou monter 500 Mo en production, c’est plus qu’agréable d’avoir un débit conséquent. Rien de plus gênant que de devoir perdre du temps à envoyer un PDF de 20 Mo à un correspondant.

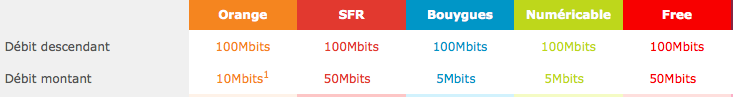

Si j’avais le choix, une offre fibre pour particulier à 100 Mb/s descendant 50 Mb/s montant, doublée avec une SDSL ou ADSL standard chez un autre FAI, conviendrait à merveille en terme de qualité de service et de capacité en débit.

En pratique notre bureau n’est pas connecté aux réseaux fibrés résidentiels, donc il faut composer autrement.

Débits et prix

L’ADSL c’est du 20 Mb/s descendant, 1 Mb/s montant, pour 30 à 40 € TTC mensuels, moitié plus cher si on prend un FAI « pro » avec une GTR de 4h. Les offres sont assez cohérentes.

Côté SDSL l’offre imbattable côté prix c’est OVH qui propose 5 Mb/s symétriques sur une paire de cuivre pour 30 € par mois, sans engagements ni frais d’installation ou résiliation. Les concurrents ont eu beau me soutenir que ces débits étaient impossibles sur une unique paire de cuivre, j’ai pu constaté que les 5 Mb/s sont effectivement atteints. Si vous voulez du GTR 4h (heures ouvrées) on passe à 100 € par mois avec un engagement d’un ou deux ans et des frais d’installation. Sur cette dernière il est possible de cumuler jusqu’à 4 paires de cuivres pour un débit de 20 Mb/s symétrique (mais la facture augmente).

Chez la concurrence en SDSL c’est la vraie jungle. Le plus souvent c’est limité à 2 Mb/s par paire de cuivre et avec un prix aux alentours de 200 € mensuels par paire, plus des frais d’installations et un engagement de deux ans. Parler de 8 Mb/s c’est quadrupler les prix, tout simplement. Seul Colt propose du 5 Mb/s sur une seule paire, mais à 500 € mensuels. Tous ces prix sont avec une GTR, en général de 4h en heures ouvrées.

Si on souhaite monter un peu en débit il faut passer par des offres « fibre ». Là il faut sortir le portefeuille. On parle assez rapidement de 750 à 1500 € mensuels pour 10 Mb/s, sans compter le raccordement initial.

La GTR, la haute disponibilité

On peut facilement se dire qu’une coupure est inacceptable, empêchera les gens de bosser, de recevoir les coups de téléphone. C’est souvent vrai mais outre la question « quel montant est-il raisonnable d’investir pour éviter une coupure ? », il faut bien penser à « ce montant me garantit-il vraiment contre une coupure ? »

La GTR et le débit garanti ce sont les deux mots de tous les commerciaux qui vendent de la SDSL. En pratique ne vous y trompez pas : Une GTR de 4h en heures ouvrées, ça veut dire que votre ligne peut tomber une demie journée et ne la voir réapparaitre que le lendemain matin. Hors cas exceptionnel, la qualité ne sera donc pas forcément meilleure qu’une ligne résidentielle grand public.

Sur les cas graves on peut compter avoir des équipes qui interviennent avec plus de sérieux et plus d’implication mais le GTR ne « garantit » en fait rien. Il vous permet juste de récupérer une faible partie de la facture mensuelle si l’accès n’est pas rétablit.

Si le problème est au niveau du répartiteur ou de la boucle locale, il est probable que ça ne change rien au temps de rétablissement. Si le problème est au niveau du FAI, avoir une seconde ligne en parallèle chez un second FAI vous coûtera probablement moins cher que la GTR « pro » tout en ayant un bénéfice bien plus grand.

Le plus symbolique c’est bien l’offre OVH où la même connexion passe de 30 € à 100 € en ajoutant la GTR. La techno est la même, l’infra est la même. Je veux bien croire que l’équipe sera un peu plus réactive, mais si la résidentielle tombe c’est probablement que la pro serait tombée aussi, et les temps de rétablissement réels ne seront pas foncièrement différents. L’équipe commerciale OVH confirme d’ailleurs très bien ça au téléphone en disant que l’offre avec GTR c’est « pour ceux que ça rassure ».

La gamme de choix

En montant une SDSL OVH doublée par une ADSL standard d’un autre FAI on est loin d’être « sans risques » mais c’est un risque qui peut probablement être assumé.

Le choix du pauvre c’est donc un 60 € par mois pour le couple SDSL + ADSL. Pour le même prix ça permet d’utiliser l’un ou l’autre suivant qu’on a besoin de débit montant ou descendant. Le résultat c’est un peu 20 Mb/s en descendant, 5 Mb/s en montant (si vous êtes proche du sous-répartiteur).

Pour ajouter quelques bretelles on peut prendre la GTR sur la ligne OVH, et une offre avec clef 3G de secours côté ADSL SFR. La GTR permet de combler les problèmes simples, et la clef 3G permet de border si c’est quelque chose de grave et long. Ça ne sera pas idéal, ça ne couvre pas tous les cas, mais ça reste abordable pour 150 € mensuels.

Monter en débit demandera un investissement de 100 € mensuels par paliers de 5 Mb/s sur la SDSL. La fibre et les liaisons dédiées n’auront de sens que si vous ne pouvez vraiment accepter aucune coupure (mais sans vous faire d’illusions : vous en aurez quand même), si vous voulez plus de 20 Mb/s (mais la facture sera multipliée par 5 rien que par le changement de techno avant même de dépasser les 20 Mb/s), ou si vous n’êtes pas proches d’un sous-répartiteur (mais peut être que déménager la PME coûtera moins cher que de passer par une fibre).

Si vous montez une boîte techno, être sur de la fibre résidentielle à 45 € par mois vous sauvera pas mal de cash les premiers temps. Ça vaut le coup de le prendre en compte dans votre localisation initiale.

![Formulaire d'inscription SFR [saisir le ] nom utilisé lors de votre commande en majuscule et sans accent [et] le téléphone fixe actuel](http://n.survol.fr/wp-content/uploads/2012/08/sfr.png)