Je vois trop d’articles ainsi, et beaucoup sur la question de la dangerosité du vélo. Jouer avec les statistiques c’est bien, mais il faut un minimum de mise en contexte si on ne veut pas raconter n’importe quoi.

Ainsi, 80% des accidents mortels ont lieu entre véhicules motorisés uniquement. Alors convaincu?

Pas du tout. Quelle est la proportion de véhicules motorisés et non motorisés sur la route ?

Les véhicules motorisés ont beau faire 80% des accidents mortels, si au final ils représentent plus de 80% de la circulation – ce qui est probable – ils peuvent tout à fait être en fait *moins* dangereux que les autres.

En fait c’est encore plus complexe car ici on parle des accidents entre véhicules motorisés *uniquement*. Il faudrait plutôt comparer d’un côté ceux qui se font « avec un véhicule motorisé » et de l’autre ceux qui se font « avec un vélo ». Bien entendu certains compteront dans les deux catégories. Ou, suivant ce qu’on veut calculer, regarder en fonction du responsable de l’accident.

72% des piétons sont blessés par une voiture, quand seulement 2% le sont par un cycliste

Ok, maintenant le vélo représente-t-il plus ou moins de 2% de la circulation ? S’il représente plus de 2% de la circulation, alors on peut considérer qu’il est moins dangereux pour les piétons. Si à l’inverse il représente moins de 2% de la circulation, alors on peut considérer qu’il est *plus* dangereux qu’un autre moyen de transport.

Pour aller même plus loin, si la voiture représente plus de 72% de la circulation et qu’en même temps le vélo en représente moins de 2%, le vélo serait même plus dangereux qu’une voiture pour les piétons.

L’article n’a aucun chiffre sur les proportions de circulation. Je n’en ai pas plus. Je ne sais pas si le vélo est dangereux ou pas, pour lui ou pour les autres, avec casque ou sans casque.

La chose que je sais c’est que rien dans les chiffres donnés ne permet de tirer une quelconque conclusion à ce niveau. Toutes les affirmations et argumentations de l’article source présentent le même défaut d’analyse statistique : Utiliser des chiffres absolus sans mise en contexte.

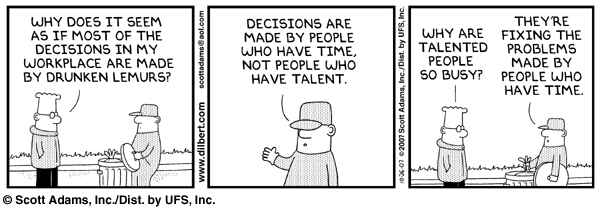

J’aime bien citer une superbe (fausse) argumentation dans le même genre :

Je vous recommande de mettre des chemises au boulot, car il y a beaucoup plus d’accidents du travail graves sur des gens en tshirt que sur des gens en chemise.

Bien entendu avec la mise en contexte on se rendra compte que les gens en chemise sont généralement dans les bureaux et que les ouvriers ou personnes faisant des travaux risqués portent habituellement des tshirts (mise en contexte), que la proportion d’accident est liée au type d’activité et non à l’habillement (causalité vs corrélation)… mais tout ça n’est qu’un détail.

Photo d’entête sous licence CC BY-NC-ND par Michael Donovan