Je cherche de quoi faire mon prochain NAS.

Mon idéal serait un petit boitier fanless avec un CPU type i5 ou i7 de dernière général (ou équivalent chez AMD), un port Thunderbolt, ainsi qu’au moins un espace pour disque 2.5″ et un pour NVMe. Je peux me contenter d’un CPU plus raisonnable mais j’aimerais garder quelque chose qui n’est pas juste du minimum.

Malheureusement ce n’est pas une configuration que je trouve facilement, encore moins à prix raisonnable.

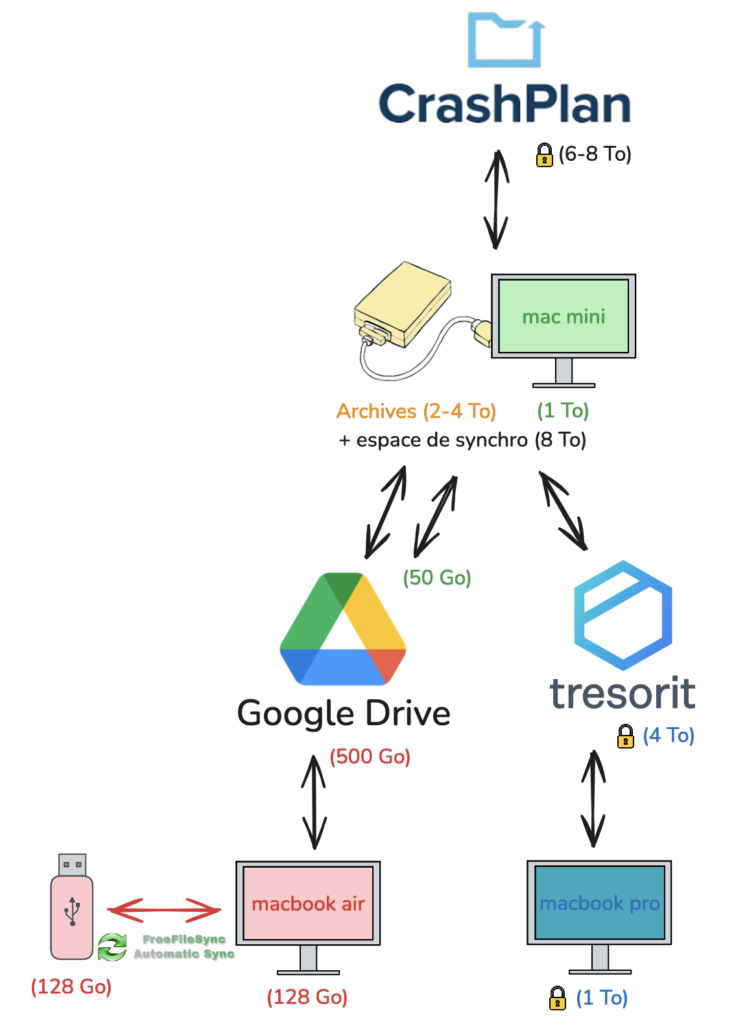

Une alternative serait un Mac Mini. Ça me permettrait de l’utiliser comme poste de bureautique d’appoint. Ça n’est pas fanless mais ils ne ventilent quasiment pas. Le défaut est que ça demande de mettre un disque externe par USB et que ce n’est pas vraiment fait pour tourner ainsi 24/7.

Est-ce que vous auriez des suggestions ?

La petite FAQ, parce que je vous connais…

Tu utilisais quoi et pourquoi changer ?

J’avais un Shuttle XS35V4 depuis 8–10 ans dans lequel j’avais fini par ajouter un module de RAM supplémentaire pour arriver à 8 Go et sur lequel je faisais tourner un Linux de base. Il se bloque systématiquement au bout de quelques jours depuis plus d’un an, le rendant un peu inutile pour mes backups. J’ai tenté la réinstallation logicielle, mais sans résultat.

Tu fais quoi avec ?

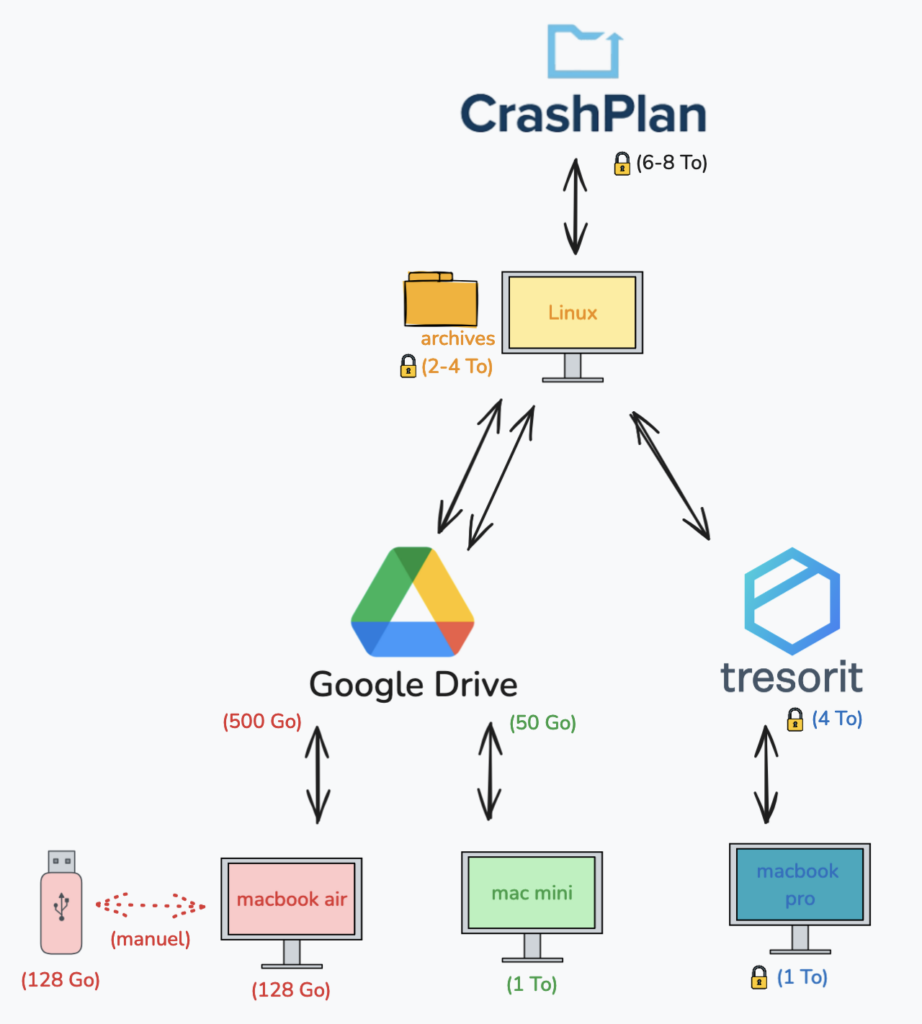

Le NAS me sert d’accès local mais aussi de hub pour centraliser la sauvegarde.

Mes fichiers persos sont synchronisés en ligne avec Tresorit, qui me permet le chiffrement de bout en bout. Ceux de ma femme sont sur pCloud. On a du Google Drive et d’autres trucs qui trainent. Le NAS va aussi sauvegarder mes dépôts git, stocker une copie de tous mes emails, et synchroniser ou récupérer en local tout ce qui traine un peu partout à moi sur Internet.

Tout est stocké sur un disque en local, chiffré au repos, et accessible localement via SMB. C’est aussi sur ce disque que je stocke mes archives, qui elles ne sont dupliquées nul part ailleurs.

Le NAS lui-même est sauvegardé en ligne avec du chiffrement de bout en bout, histoire d’avoir une copie hors-ligne historisée. J’avoue que je me sers parfois de cette sauvegarde en ligne pour récupérer à un fichier d’archive quand je suis hors de chez moi.

Pourquoi autant de puissance ? C’est démesuré pour un NAS

Certains logiciels de synchronisation de fichiers ne sont pas faits pour tourner en pure ligne de commande. J’ai donc un desktop Linux qui tourne 24/7. Certains de ces logiciels sont aussi particulièrement gourmands en RAM. Rien que Crashplan m’a forcé à monter à 8 Go de RAM pour ne pas planter lors des déduplications. Côté CPU je suis un gros adepte de chiffrement pour mes données donc tout ça fait du chiffrement de partout.

Enfin, parfois le NAS m’a servi comme PC bureautique secondaire, et là j’ai vraiment souffert.

L’expérience m’a montré que les caractéristiques actuelles étaient probablement le plancher et que j’aurais plutôt intérêt à chercher plus puissant en CPU. Avoir la capacité d’augmenter la RAM un jour ne ferait pas de mal aussi.

Ce serait potentiellement différent si je remplaçais mes logiciels de synchronisation et de backup par des choses plus efficaces et en pure ligne de commande, mais avec des si…

Pourquoi Fanless ?

J’ai besoin de pouvoir connecter ce NAS à un écran. Il sera donc soit sur mon bureau de travail soit à côté de la télévision. Dans les deux cas je suis très réfractaire à un bruit de ventilateur. J’ai toujours regretté par le passé les options avec ventilation active à cause de ça, et j’avais beaucoup apprécié par le passage en fanless.

Pourquoi pas Synology ou autre NAS dédié ?

Certains logiciels que j’utilise ne fournissent de binaire que pour x86 ou Apple Silicon. Côté OS j’ai bien du Linux mais c’est déjà un peu bancale et ça ne tournerait pas sur des Linux moins standard. Certains logiciels ont d’ailleurs besoin d’une interface graphique desktop.

Ces NAS ne sont de plus jamais fanless à la connaissance. Mes expériences passées avec Synology me les font exclure à cause du bruit.

Quel est ton budget ?

Le moins cher possible, mais sans limite haute ;-)

Si j’ai l’impression que ça vaut le coup, que ça me libère de nouveaux usages (par exemple s’en servir aussi comme vrai poste de travail), je peux mettre le prix qu’il faut.