J’ai craqué et j’ai commandé l’écran (Dell U4025QW) il y a deux mois.

Je veux rédiger ce billet depuis les deux premières semaines mais je n’ai pas su comment le tourner. Ça sera donc un peu brouillon.

Je regrette d’avoir tant hésité

Je crois que c’est le ressenti principal.

Changer ses habitudes est difficile. J’ai eu des setups sans écrans externes, avec un 24″, avec un 32″, avec deux 24″ en paysage, avec un en paysage et un en portrait. J’ai même pu tester un 34″ ultra-large. À chaque fois je me retrouvais régulièrement sur l’écran du macbook comme écran principal. Les écrans secondaires restaient accessoires. Un vrai confort mais accessoire.

Ici il ne m’a pas fallu une semaine pour avoir envie de fermer le macbook entièrement, et je le garde fermé depuis.

De l’espace horizontal

Je voulais de l’espace horizontal, pouvoir mettre deux ou trois fenêtres côte à côté. Ça devenait d’autant plus pertinent pour la programmation où l’IA prend un second espace complet à côté de l’espace pour le code.

Les fenêtres sont un peu plus étroites que d’ordinaire mais j’en mets bien trois. À vrai dire, surtout côté web, j’ai l’impression d’avoir surtout perdu de l’espace vide. Je n’affiche rien de moins.

C’est aussi parfait pour l’édition photo, qui était mon troisième usage. Lightroom permet d’afficher ma photo entière, en plus des panneaux de droite et de gauche.

Le pari c’était de trouver le plus large possible mais sans que ça ne devienne inutile ou gênant. J’ai l’impression que c’est réussi.

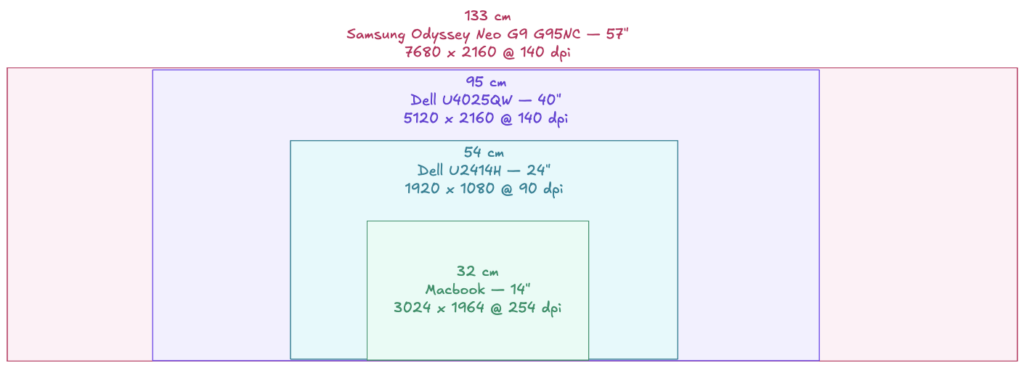

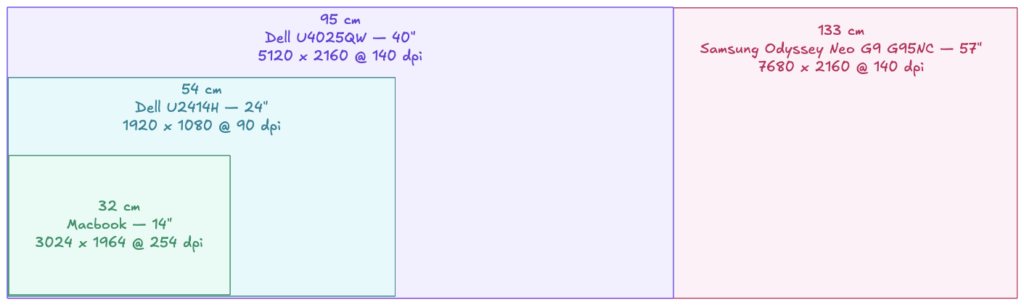

L’écran fait pas loin de 90 centimètres de large, 30% de plus qu’un 32″. Je ne vois déjà pas les deux côtés sans bouger un peu les yeux. Peut-être est-ce le temps de m’habituer, mais j’ai l’impression que plus large serait non seulement inutile mais probablement contre-productif, à me faire tourner la tête de droite à gauche.

De l’espace vertical

J’ai hésité avec des écrans beaucoup moins chers en 32:9ème. Je craignais d’avoir un ratio avec trop peu de hauteur.

J’apprécie d’avoir pas mal de contexte sur une documentation ou sur du code, et de pouvoir travailler une photo en pleine taille. C’est aussi pratique sur les feuilles de calcul.

Ce que je n’avais pas anticipé c’est les visio conférences où je vois le partage d’écran en taille appréciable malgré l’espace pris en haut et en bas.

J’ai un peu moins de 40 centimètres en hauteur, l’équivalent d’un 32″. Là aussi c’est pari réussi, même si j’aurais peut-être pu me contenter de moins.

Des pixels, plein de pixels

J’ai écarté beaucoup de précédent modèles parce qu’ils avaient une densité de pixels assez faible. Je ne vois pas les pixels, mais le ressenti de qualité est flagrant entre un écran classique 96–110 ppi et un écran double densité dans les 215–225 ppi (les apple-fan parleront de retina).

Ici on est à 140 ppi. Les intermédiaires c’est un peu risqué parce que la mise à l’échelle n’est plus un simple facteur 2. C’est un compromis, mais un écran large en 220 ppi ça n’existe pas, et ça demanderait un nombre de pixels que le thunbderbolt 5 de mon macbook ne saurait pas gérer.

J’ai l’impression que c’est réussi. Sur macos, betterdisplay permet de profiter de la mise à l’échelle qualitative. Je dois avouer qu’il m’arrive toutefois exceptionnellement de le passer à la résolution native.

De la courbure

La courbure c’est le côté qui m’a fait peur. J’ai vu un 34″ droit et je sais que c’était pénible. D’un autre côté les écrans gaming avec leur courbure très prononcée me semblaient vraiment exagérées, surtout pour de l’édition photo.

Bref, là j’ai une courbure légère, qui se fait oublier mais qui me semble pertinente.

De la luminosité et du contraste

C’est peut-être le seul point où j’aurais aimé plus. La luminosité est correcte mais je suis souvent proche des 100%. Je vois la différence avec l’écran du macbook et je n’aurais pas craché sur plus.

Là aussi c’est un compromis. Des écrans de cette taille avec plus de luminosité ça ne court par les rues. Il y aura peut-être un 40″ en OLED dans quelques années mais il y aura toujours une raison d’attendre quelques années de plus, et je suis satisfait de ce que j’ai ici.

Utilisation pratique

J’ai le laptop branché en USB-C, pro ou perso suivant le moment de la journée, fermé sur le côté. La charge est intégrée.

Le clavier et le trackpad sont branchés par cable sur les deux ports USB-C de la face avant. J’aurais préféré les garder en bluetooth mais les brancher fait qu’ils passent automatiquement sur le laptop qui est connecté. La webcam est branchée sur le hub en face arrière et passe elle aussi automatiquement sur le laptop que je connecte.

Le vrai logiciel indispensable c’est betterdisplay, pour la mise à l’échelle comme dit plus haut, mais aussi parce que ça permet d’intercepter les commandes de luminosité et de volume du clavier pour les transmettre à l’écran.

Plusieurs postes

J’ai aussi découvert le partage du clavier et du trackpad entre mac et c’est juste le bonheur. Les deux mac s’auto-détectent tout seuls. Je peux accéder au second laptop comme si c’était un écran supplémentaire, et interagir avec. Ça gère même le copier/coller de façon transparente entre les deux. Quand j’ai besoin de faire un peu de pro au milieu d’une session perso, ou le contraire, il suffit que j’ouvre le laptop sur le côté et c’est parti.

Ça plus handsoff (pour transférer la tâche en cours) et airdrop (pour transférer les fichiers), l’écosystème intégré est quand même plus que confortable.

Tout est transparent, et c’est parfait pour moi.

Le Dell a aussi un hub avec KVM intégré pour utiliser deux sources, un seul écran un seul clavier mais je n’ai probablement pas le droit d’installer un outil qui intercepte clavier et trackpad sur mon ordinateur pro. J’ai fait sans et pour l’instant je ne vois pas trop ce que ça m’apporterait de plus.

Ok, mais est-ce que ça vaut le coup ?

Si on oublie le prix, c’est un grand oui. Je ne vois pas de meilleur choix sur le marché pour une utilisation mixte édition-bureautique.

Il reste que c’est aussi un des plus chers du marché. J’ai la chance de l’avoir pris en promotion et sur du professionnel donc avant taxes et tva, mais même ainsi ça reste cher. On a des écrans larges pour beaucoup moins cher que ça, avec un peu de compromis.

Pas pour le jeu ultra-rapide

ni pour le HDR de précision

Et parce qu’on m’a interrogé là dessus : L’écran monte en 120 Hz mais le temps de réaction des pixels n’est pas très bon.

Ce n’est pas un bon écran pour faire du jeu ultra-rapide genre shoot-them-up. Pour des jeux plus lents, genre un factorio, je ne vois rien à y redire (et l’espace disponible est vraiment agréable).

De même, si le rendu des couleurs est correct en HDR, il y a peu de zones distinctes pour la luminosité. Ce ne sera pas le meilleur pour des films en HDR ou du HDR de précision.

Bref, bureautique et édition plutôt que jeux et films. On ne peut pas avoir un écran qui fait tout.