J’adore le principe de la wayback machine de l’initiative Internet Archive. Ils indexent le web et gardent une archive des versions rencontrées. On peut revoir les contenus qui ont disparu du web, ou consulter des anciennes versions de contenus qui ont changé entre temps.

Et si on réutilisait l’initiative à titre personnel ? Pouvoir retrouver les contenus déjà visités, même s’ils ont été retirés ou ont été amendés. Avec un peu de bidouille on pourrait même rechercher à travers nos archives.

C’est ce que propose l’IIPC avec le projet openwayback. Pour ceux qui ne veulent pas utiliser pywb.

Je pense de plus en plus à me constituer mon archive : Au moins avec les pages que je mets en favori, celles que je lie à partir de mon blog, les liens que j’enregistre dans Pocket, que je lis dans mon flux Twitter ou que j’y pose moi-même. Peut-être même que ça vaudrait le coup d’enregistrer tout ce qui passe dans mon historique de navigation.

Pour l’instant je n’ai jamais sauté le pas, mais est-ce si complexe ? pas certain. Il suffirait d’un peu de temps, d’un peu de code et de stockage en assez grande quantité. Rien d’infaisable.

Entre temps, d’autres se mettent en tête d’archiver le web, tout le web. Rien que ça. L’Internet Archive n’est qu’une composante parmi d’autres reliées grâce à Memento. L’Archive Team fait un travail parallèle : Eux réussisent à archiver les contenus de quelques services en vue avant qu’ils ferment, les contenus des redirecteurs d’URL, et même les contenus FTP.

Le web grossit à une vitesse formidable mais les possibilités de stockage restent suffisamment importantes pour qu’archiver le web soit du domaine du possible.

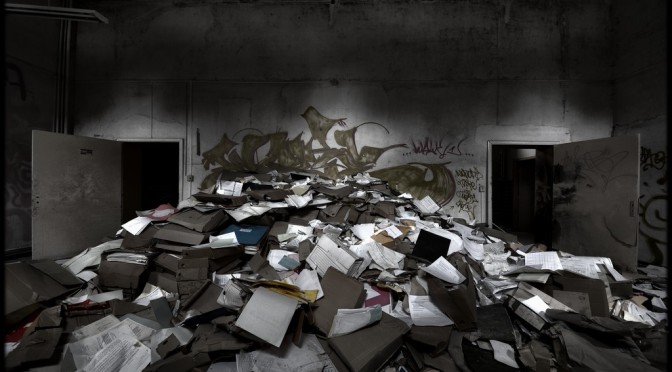

Photo d’entête sous licence CC BY-NC-ND par Pietromassimo Pasqui

Laisser un commentaire